首页 > 安防资讯网 腾讯混元大模型亮相:全链路自研,聚焦应用死磕“幻觉”

腾讯混元大模型亮相:全链路自研,聚焦应用死磕“幻觉”

9月7日,在2023腾讯全球数字生态大会上,腾讯混元大语言模型正式亮相,并宣布通过腾讯云对外开放。这是腾讯首次披露的通用大语言模型,具备强大的中文创作能力,复杂语境下的逻辑推理能力,以及可靠的任务执行能力。

此前的大半年,国内云厂商跟随ChatGPT,掀起“百模大战”。一时间,国内生成式大语言模型多得让人眼花缭乱。腾讯在市场激流勇进之后再“秀肌肉”,也映射了“混元”这个取自典籍的名字中“元气生于混沌之中”的含义,它拨清迷雾,迎接新天地。

腾讯为什么此前不着急发通用大模型?在蛰伏的日子里,腾讯做了什么?腾讯混元大模型值得期待吗?

“不急于把半成品拿出来展示”

在“百模大战”经历喧嚣,逐渐降噪之时,腾讯不紧不慢地揭开自己大语言模型的神秘面纱,这体现了腾讯一如既往的风格——不争一时热度、用产品实力说话。

在今年5月腾讯2023年股东大会上,腾讯董事会主席兼首席执行官马化腾就如此评价大模型:“我们最开始以为这是互联网十年不遇的机会,但是越想越觉得这是几百年不遇的、类似发明电的工业革命一样的机遇。互联网企业都有很多的积累,都在做,我们也一样在埋头研发,但是并不急于早早做完,把半成品拿出来展示。”

马化腾认为,对于工业革命来讲,早一个月把电灯泡拿出来在长的时间跨度上来看是不那么重要的。大模型之于互联网技术革命,就如电灯之于工业革命。腾讯在乎的是这个“电灯”的实用性和耐用性,而不是死盯着早一步投入市场激起的那簇虚无的水花。

“关键还是要把底层的算法、算力和数据扎扎实实做好,而且更关键的是场景落地。”马化腾说道。

在市场看不见的日子里,腾讯已经在大模型底层能力上埋头钻研多年。从2021年开始,腾讯先后推出千亿和万亿参数的NLP稀疏大模型,打破CLUE三大榜单纪录,实现在中文理解能力上的新突破。

在去年年末ChatGPT掀起大模型浪潮后,腾讯的大模型路线也稳扎稳打,利用自身多元且丰富的产品、数据、场景的优势,迭代了多个版本。腾讯的大模型在丰富的内部场景和应用上进行了反复锤炼,更清楚一个深入业务的大模型应该如何设计和研发。

相比于国内外已发布的大语言产品主要是通过聊天场景进行测试和训练,腾讯选择了用自家产品来测试。在腾讯集团副总裁蒋杰看来,测试大语言模型的途径有很多。“一种是通过Chat来验证,这会有比较好的体感。而腾讯有20多年的发展历史,有海量的用户和TO C的应用场景、TO B的验证体系,用它们来测试或许会有更好的效果。”蒋杰表示。

就这样,腾讯强大的产品矩阵,成为了混元大模型语料训练的“养料”,也是场景应用的“磨刀石”。至今,腾讯混元大模型拥有超千亿参数规模,预训练语料超2万亿tokens。

目前,混元大模型已经接入腾讯50多个业务并取得初步效果,包括腾讯云、腾讯广告、腾讯游戏、腾讯金融科技、腾讯会议、腾讯文档、微信搜一搜、QQ浏览器等业务和产品。这其中既包括了C端应用,也包括了B端场景,其应用和测试的体量足以比拟甚至超越国内一些先发的其他大模型。

在腾讯全球数字生态大会上,腾讯正式宣布,混元大模型将作为腾讯云MaaS服务的底座,客户不仅可以直接通过API调用混元,也可以将混元作为基底模型,为不同产业场景构建专属应用。

自研的底气

慢即是快,这是腾讯长期遵循的产品哲学。少了仓促的赶场,多了扎实的自研技术和创新优势。

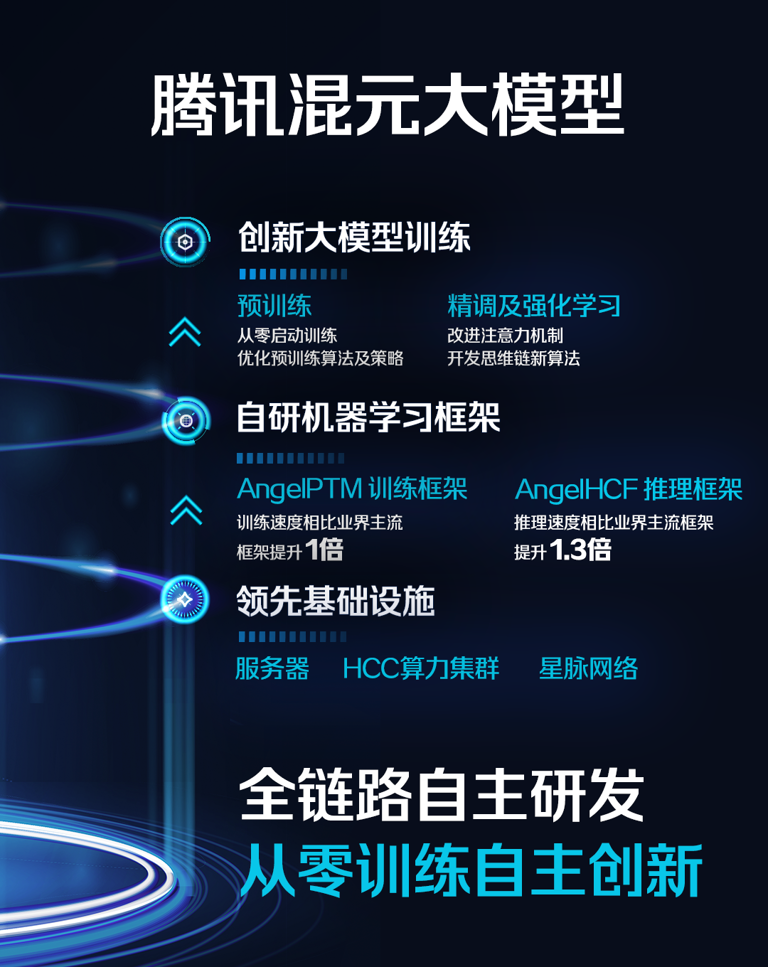

全链路自研是腾讯混元大模型的亮点。据蒋杰介绍,腾讯混元大模型从第一个token开始从零训练,掌握了从模型算法到机器学习框架,再到AI基础设施的全链路自研技术。这其中包括大规模、高质量、多样化的语料库、创新的大模型算法和训练方法、自研Angel机器学习框架、强大的算力基础设施等。

全链路自研带来的效果,是显而易见的。举个例子,目前生成式AI在实际场景的应用比较受限,大部分停留在高容错、任务简单的休闲场景,例如诗词生成。用户在初尝大模型时,往往会因其炫技式的作诗或者回答脑筋急转弯而感到惊艳,然而,对于容错率更低或任务更复杂的工作、专业以及严肃场景,如客服助手、医疗诊断、调研统计等领域,往往容易出现张冠李戴、胡言乱语的问题(即大模型“幻觉”),导致用户对准确性和可靠性的呼声极高。

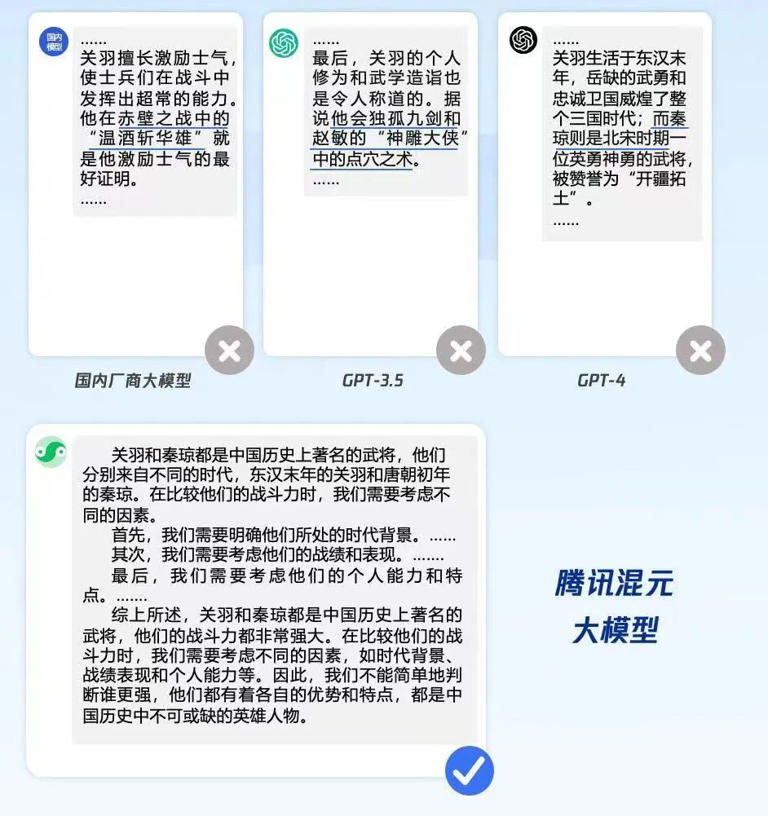

可以说,“幻觉”扼住了大模型大规模应用的“咽喉”,让企业和个人面临严肃的需求时,不敢放心使用。对此,业界往往通过知识图谱或者搜索外挂的方式试图解决,但效果并不理想。而腾讯混元大模型给出的方案是——不依赖外挂,在预训练阶段通过“探真”算法进行事实修正,让混元大模型的幻觉相比主流开源大模型降低了30%至50%。

不仅是降低幻觉,腾讯混元大模型还通过强化学习的方法,让模型学会识别陷阱问题;通过位置编码优化,提高了超长文的处理效果和性能;提出思维链的新策略,让大模型能够像人一样结合实际的应用场景进行推理和决策。它还能进行文学创作、文本摘要、角色扮演等内容创作,做到充分理解用户意图,并高效、准确地给出有时效性的答复。

此外,腾讯还自研了机器学习框架Angel,使训练速度相比业界主流框架提升1倍,推理速度较业界主流框架提升1.3倍。

放眼市场,有众多的开源大模型可以提供给厂商进行叠加和使用。相反,全链路自研就显得并不取巧。那么,腾讯为何坚持做自研?蒋杰有自己的答案:“首先,如果企业不从头开始做自研的话,就缺乏对这个技术的完全掌握;第二,腾讯大模型的自研,能够加速后续的迭代,加快与其他业务的深度结合和绑定。对于腾讯那么多海量高并发的业务来说,开源架构无法应对冲击,对腾讯来说是并不合适的。所以我们一定要走出一条基于自主体系的研发道路。”

在大模型扎堆的当下,全链路自研给了腾讯底气。在中国信通院《大规模预训练模型技术和应用的评估方法》的标准符合性测试中,混元大模型共测评66个能力项,在“模型开发”和“模型能力”两个重要领域的综合评价均获得了当前的最高分。在主流的评测集MMLU、CEval和AGI-eval上,混元大模型均有优异的表现,特别是在中文的理科、高考题和数学等子项上表现突出。

业务的倍增器

“我们研发大模型的目标不是在评测上获得高分,而是将技术应用到实际场景中。腾讯将全面拥抱大模型。”蒋杰说道。这也反映了腾讯从实践中来,到实践中去的产品初心。

在大会上,蒋杰展示了腾讯会议、腾讯文档、腾讯广告等多个业务,在接入腾讯混元大模型后的实际应用情况。

其中,腾讯会议基于混元大模型打造了AI小助手,只需要简单的自然语言指令,就能完成会议信息提取、内容分析等复杂任务,会后还能生成智能总结纪要。据实测,在指令理解、会中问答、会议摘要、会议待办项等多个方面,混元大模型均获得较高的用户采纳率。

例如在广告场景,腾讯混元大模型支持智能化的广告素材创作,能够适应行业与地域特色,满足千人千面的需求,实现文字、图片、视频的自然融合。此外,基于混元大模型的能力,广告智能导购能够帮助商家在企业微信等场景,提升服务质量和服务效率。

在8月的财报电话会中,腾讯总裁刘炽平表示:“就生成式AI技术,或广泛地对于基础模型而言,我们认为此类技术和机会并不仅局限于聊天机器人这样的问答式体验。从更广泛来看,我们对AI了解越多,就越对它作为我们业务的倍增器感到期待。AI技术将有助于提高用户交互服务的效率和质量,促进我们的广告定位、数据定位能力,以及提升许多内容生产的效率。因此,通过持续发展生成式AI,我们将能从多个方面受益。”

在腾讯看来,混元大模型的想象空间远不止目前呈现给公众的效果。像人类一样,它能持续训练、终身学习,训练数据集会持续更新,不断学习更新最新知识,以改善其性能和准确性。同时,混元大模型也将为腾讯在6月发布的模型即服务(MaaS)解决方案释放更多市场潜力。

蒋杰介绍道,腾讯9月7日发布的通用大语言模型,也将作为腾讯云MaaS服务的底座,进一步服务更多的行业客户。不仅如此,最近,腾讯云也全面接入Llama 2、Bloom等20多个主流模型,和混元一样,都支持直接部署调用。客户可以根据实际需求,基于混元、基于开源模型,打造自己专属的行业大模型。

现在,混元大模型已经不是半成品了,但按照腾讯的高标准,还达不到“成品”的程度。“我认为混元永远在路上,现在推出的版本只是可用,但我们一直在演进我们的能力,例如从大语言模型演进到文生图。今天只是一个开始,我希望我们每个月都会给大家惊喜。”蒋杰最后说道。

编辑|蒙锦涛

责任编辑:

文章来源://www.profoottalk.com/2023/0908/9053.shtml