首页 > 安防资讯网 AI计算加速800G光模块部署

AI计算加速800G光模块部署

近年来,在人工智能计算需求不断增长的推动下,对GPU和其他计算硬件的需求急剧飙升。仅今年一年,英伟达的股价就上涨了200%以上,这一点显而易见。此外,由于数据中心的人工智能训练需要高速数据传输,对人工智能服务器集群的需求也急剧上升。随着数据中心基础设施的不断扩大,光模块的使用量呈指数级增长。目前,200G和400G光模块已经大规模部署,800G光模块已经开始进入量产和引进阶段。

为什么需要800G光模块?

数据中心内的数据传输主要分为南北流量和东西流量两个方向。南北向流量是指数据中心外用户与内部服务器之间的数据传输,东西向流量是指数据中心之间以及数据中心内服务器之间的数据传输。随着ChatGPT引爆的AI大模型市场,数据中心的东西流量和内部服务器流量比例增加。

更新数据中心拓扑结构

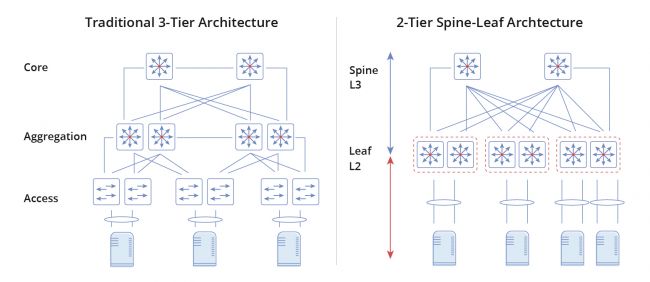

数据中心计算规模和东西向流量不断扩大,数据中心网络架构也在不断变化。在传统的三层拓扑结构中,服务器之间的数据交换需要经过接入交换机、汇聚交换机和核心交换机。这给汇聚交换机和核心交换机带来了巨大的工作压力。

三层拓扑:如果采用传统的三层拓扑,进一步扩大服务器集群的规模,则需要在核心层和汇聚层部署高性能设备,设备成本将大幅增加。

两层Spine-Leaf拓扑:Leaf-Spine拓扑将传统的三层架构扁平化为两层架构。在这种设置中,叶子交换机(类似于传统三层架构中的访问层交换机)直接连接到服务器。骨干交换机,相当于核心层交换机,直接连接到叶交换机,每个骨干交换机连接到所有叶交换机。

AI计算和800G光模块

与传统的三层拓扑结构相比,脊叶结构需要大量的端口。因此,无论是服务器还是交换机,都需要更多的光模块来进行光纤通信。对于使用gpu的广泛AI训练应用,在NVIDIA的DGX H100服务器中,集成了8个H100 gpu,对计算和存储网络的需求相当于大约12个800G光模块和18个400G光模块。更多信息可以在这篇文章中找到:NVIDIA DGX H100简介。

这表明在叶脊架构下,数据中心对高速光模块的需求呈指数级增长。随着数据中心规模的扩大,特别是对AI大型模型训练的需求,以及GPU服务器对更高传输速率的需求增加,800G光模块的采用速度正在加快。

加速部署800G光模块

在人工智能计算进步的背景下,800G模块的需求正在稳步上升,全球领先的制造商加大了部署力度。

例如,星际光学公司已经在2023年上半年开始增加800G光模块的生产,与gpu匹配的800G产品一起稳定地向海外主要客户交付。

在OFC 2023上,海信宽带推出了业界首款800G QSFP-DD BiDi SR4.2光模块产品,并展示了800G QSFP-DD SR8、800G OSFP SR8、800G OSFP 2xFR4/DR8、800G QSFP-DD 2xFR4/DR8等基于PAM4信令的800G系列光模块产品,展示了全面的产品系列。

总结

随着GPU订单驱动需求的确定性,800G光模块的批量出货阶段将从今年下半年开始。800G光模块作为人工智能计算能力的重要一环,在数据中心规模不断扩大和人工智能培训需求持续增长的推动下,市场增长和部署速度将加快。

责任编辑:

文章来源://www.profoottalk.com/2024/0321/11048.shtml